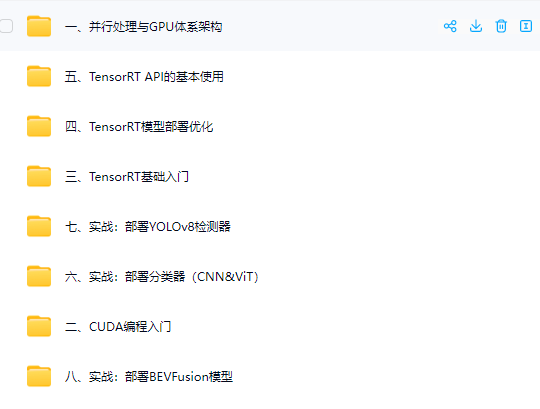

网盘截图:

课程目录:

/├─一、并行处理与GPU体系架构

│ 001.第一章课件 并行处理、GPU体系架构与课程简介.pdf

│ 002.1.0 课程介绍_ev.mp4

│ 003.1.1 并行处理简介_ev.mp4

│ 004.1.2 GPU并行处理_ev.mp4

│ 005.1.3.1 环境搭建_ev.mp4

│ 006.1.3.2 CUDA cuDNN TRT版本选择_ev.mp4

│ 007.1.3.3 常用软件安装_ev.mp4

│ 008.1.3.4 服务器的环境配置_ev.mp4

│ 009.1.3.5 编辑器的环境配置_ev.mp4

│

├─七、实战:部署YOLOv8检测器

│ 001.7.1 load-save-tensor_ev.mp4

│ 002.7.2 affine-transformation_ev.mp4

│ 003.7.3 deploy-yolov8-basics_ev.mp4

│ 004.7.4 quantization-analysis_ev.mp4

│

├─三、TensorRT基础入门

│ 001.第三章课件.pdf

│ 002.3.1 TensorRT概述_ev.mp4

│ 003.3.2 TensorRT的应用场景_ev.mp4

│ 004.3.3 TensorRT的模块_ev.mp4

│ 005.3.4 导出并分析ONNX_ev.mp4

│ 006.3.5 剖析ONNX架构并理解ProtoBuf-上_ev.mp4

│ 007.3.5 剖析ONNX架构并理解ProtoBuf-下_ev.mp4

│ 008.3.6 ONNX注册算子的方法_ev.mp4

│ 009.3.7 ONNX graph surgeon-上_ev.mp4

│ 010.3.7 ONNX graph surgeon-下_ev.mp4

│ 011.3.8 快速分析开源代码并导出ONNX_ev.mp4

│ 012.3.9 使用trtexec_ev.mp4

│ 013.3.10 trtexec log分析_ev.mp4

│

├─二、CUDA编程入门

│ 001.第二章课件 CUDA编程入门.pdf

│ 002.2.1.1 理解CUDA中的Grid和Block_ev.mp4

│ 003.2.1.2 理解.cu和.cpp的相互引用及Makefile_ev.mp4

│ 004.2.2.1 CUDA Core的矩阵乘法计算_ev.mp4

│ 005.2.2.2 CUDA中的Error Handle_ev.mp4

│ 006.2.2.3 GPU的硬件信息获取_ev.mp4

│ 007.2.3.1 安装Nsight system and compute-上_ev.mp4

│ 008.2.3.2 安装Nsight system and compute-下_ev.mp4

│ 009.2.4.1 共享内存-上_ev.mp4

│ 010.2.4.1 共享内存-下_ev.mp4

│ 011.2.4.2 Bank Conflict-上_ev.mp4

│ 012.2.4.2 Bank Conflict-下_ev.mp4

│ 013.2.5.1 Stream与Event-上_ev.mp4

│ 014.2.5.2 Stream与Event-下_ev.mp4

│ 015.2.6.1 双线性插值与仿射变换-上_ev.mp4

│ 016.2.6.2 双线性插值与仿射变换-下_ev.mp4

│

├─五、TensorRT API的基本使用

│ 001.5.1 MNISIT-model-build-infer_ev.mp4

│ 002.5.2 build-model_ev.mp4

│ 003.5.3 infer-model_ev.mp4

│ 004.5.4 TensorRT-network-structure_ev.mp4

│ 005.5.5.1 build-model-from-scratch-上_ev.mp4

│ 006.5.5.2 build-model-from-scratch-下_ev.mp4

│ 007.5.6.1 build-trt-module-上_ev.mp4

│ 008.5.6.2 build-trt-module-下_ev.mp4

│ 009.5.7 custom-trt-plugin_ev.mp4

│ 010.5.8 plugin-unit-test(python+cpp)_ev.mp4

│

├─八、实战:部署BEVFusion模型

│ 002.8.1 Overview-and-setting-environment-_ev.mp4

│ 003.8.2 About-spconv-algorithm_ev.mp4

│ 004.8.3 Export-SParse-Convolution-Network_ev.mp4

│ 005.8.4 Spconv-with-Explicit-GEMM-Conv_ev.mp4

│ 006.8.5 Spconv-with-Implicit-GEMM-Conv_ev.mp4

│ 007.8.6 BEVPool-Optimization_ev.mp4

│ 008.8.7 Analyze-each-onnx_ev.mp4

│ 009.8.8 CUDA-BEVFusion-Framework-Design_ev.mp4

│

├─六、实战:部署分类器(CNN&ViT)

│ 001.6.0 preprocess-speed-compare_ev.mp4

│ 002.6.1 deploy-classification-basic_ev.mp4

│ 003.6.2.1 design-of-inference-model_ev.mp4

│ 004.6.2.2 deploy-classification-advanced_ev.mp4

│ 005.6.3 int8-calibration_ev.mp4

│ 006.6.4 trt-engine-explorer_ev.mp4

│

└─四、TensorRT模型部署优化

001.第四章课件.pdf

002.4.1.1 FLOPS和TOPS_ev.mp4

003.4.1.2 Roofline model_ev.mp4

004.4.2 模型部署的几大误区_ev.mp4

005.4.3.1 quantization(mapping-and-shift)_ev.mp4

006.4.3.2 quantization(quantization-granularity)_ev.mp4

007.4.3.3 quantization(calibration-algorithm)_ev.mp4

008.4.3.4 quantization(PTQ-and-quantization-analy_ev.mp4

009.4.3.5 quantization(QAT-and-layer-fusion)_ev.mp4

010.4.4.1 pruning(pruning granularity)_ev.mp4

011.4.4.2 pruning(channel level pruning)_ev.mp4

012.4.4.3 pruning(sparse tensor core)_ev.mp4